Teradata apuesta también por el open source en SaaS

Celebrado el Teradata Innovation Forum 2017 en la Fundación Giner de los Ríos en Madrid, queda claro que la analítica de datos es cada vez más una commodity, aunque todavía necesitada de casos de uso.

Lo que era hace un año un anuncio en el evento de Teradata, de abrirse a la tecnología open source, es hoy ya realidad. La compañía mostró los primeros clientes en España de Think Big Analytics, la empresa de Silicon Valley que adquirió en 2012, y repasó los puntos fuertes de su oferta. José Andrés García Bueno, director general de Teradata Iberia, dio la bienvenida a los asistentes: “Aquello que era un plan en nuestra anterior cita en el estadio Bernabéu es una realidad, con una oferta sustentada en tres pilares. El dato y la analítica marcarán la tecnología y no al revés como hasta ahora, acostumbrados a comprar antes los equipos, enchufarlos y a ver entonces qué hago con ellos; sí, tienes toda la cacharrería para el Big Data, pero no le sacas todo el valor, solo ves parpadear sus luces. Hoy podemos construir la infraestructura a medida alrededor del proyecto”.

Está la oferta evolucionada que Teradata impulsó hace 30 años con la primera tecnología warehouse y dataminig, con un fuerte enfoque en el Business Intelligent. La diferencia es que su plataforma ya no se ofrece instalada on-premise únicamente en el data center del cliente, se puede encontrar ahora también en la nube, bien en sus propios centros de datos (en Europa situados en Alemania) o bien gestionados por terceros (AWS, Azure). “El modo de comercialización también ha evolucionado. De la venta exclusiva de licencias, a la suscripción del servicio en modo por uso, lo que hace menos doloroso su adquisición. Además, ahora Teradata ofrece la opción de la portabilidad de esas licencias, que pueden ser migradas de on-premise al cloud”.

El segundo pilar es la consultoría de negocio y servicios de Data Scientifics, diseño de algoritmos e integración de entornos basados en Hadoop, Spark, Cloudera y Hortonworks. El tercer pilar también está enfocado en el software abierto, pero ofrecido a través de su división Think Big Analytics. “En este caso, no es estrictamente tecnología agnóstica, sino neutral respecto a la de Teradata. Se ofrece consultoría en múltiples entornos con arquitecturas y desarrollos, incluida la nuestra, y también sobre open source, con la ventaja de ser un player de nivel mundial por nuestra capacidad de cobertura”.

TI bimodal

Nuestro viejo conocido Stephen Brobst, CTO de Teradata Global, que nunca pierde una oportunidad de pasearse por España, ofreció su visión de los despliegues a dos velocidades bimodal IT. “Tenemos un problema si no crecemos y no innovamos. Pero mayor problema es reinventarse y no saber monetizar ese esfuerzo. Hay tres tipos de empresas: las que ya son una compañía de datos; las que llegarán a ser una compañía de datos; y las que desaparecerán por irrelevantes”.

El coste de la tecnología ha ido bajando y su consumo aumentando, y en todas las industrias se compite por precio pero los ingresos no han subido en la misma proporción que el consumo de TI. Si una operadora da gratis las llamadas de voz, ¿cómo va a hacer negocio?, piensa la gente. Pero ahora nadie llama loco a Google por ofrecer gratis servicios de correo o de mapas, fueron los primeros que entendieron que el valor de los datos es mayor que el valor de uso de esos servicios. “La innovación es muy dura. Gestionar datos como su principal activo es crucial para cualquier empresa, lo que significa optimizar la extracción de valor y saber innovar con esos activos. El conflicto se produce entre la parte que debe entregar un valor alto y la que debe crear un nuevo valor, de ahí surgen los dos modos de Analytics Deployment que señala Gardner”.

El modo 1 se encarga de manufacturar un producto de datos con foco en negocio (realizable, proceso en cascada, que cumpla una serie de requisitos, preparado para entrar en producción, escalable) y que tiene su límite en el precio de coste, y el modo 2 trata del I+D de datos con foco en la funcionalidad (flexible, metodologías ágiles, rápido prototipado y barato de fallar, experimentar con nuevas herramientas y algoritmos, reutilizable) y que tiene su meta en los ingresos que pueda generar.

“Se podría representar como que a un lado están los señores de traje y corbata que tratan con proveedores de clase Enterprise y pensando en relaciones a largo plazo, y al otro están los rarillos con camisas hawaianas que tratan con pequeñas startups y pensando solo en proyectos a corto plazo”, decía Brobst. “En medio hace falta un tercero que haga de puente, sería el de la chaqueta de sport. El que defina el proceso entre ambos modos, el que determine el valor mínimo de producto entregado para hacer que de lanzamientos cada equis meses se reduzca a cada equis semanas. En realizada, no se trata de separar, sino de cohesionar y alinear, y lo que sí está claro es que para proyectos de análisis de datos es donde el bimodal TI se revela como un gran diferencial”.

Del SecOps al AnalyticOps

Bankia se prestó a contar su caso de uso y cómo está adoptando las tecnologías analíticas para reforzar su oferta minorista y poder adecuar los productos a cada perfil de cliente. De una manera gráfica, Diana Díaz Agrela, jefa de Analítica Avanzada y Big Data, ejemplificaba su proceso como el de una familia que va a acometer una reforma en su casa: “El padre, siempre enfocado a objetivos: que a qué hora se cena, que qué notas ha sacado; la madre, que todo funcione y esté en orden: pongo la lavadora, llevo el niño al médico; y el niño, en su mundo: desmontando cacharros, chateando con amigos. Y tenemos a un artista invitado, el arquitecto, que es el que nos va a ayudar a redecorar la casa y asesorar en la compra”. Y añade: “El padre quiere resultados inmediatos y a ser posible en tiempo real; la madre, ante la posibilidad de llenar un lienzo en blanco y poder escribir una carta a los Reyes Magos, que llegue a todos los canales, procesos y departamentos; mientras, el niño sigue en sus mundos, explorando, escalando, buceando… es el científico de datos. El arquitecto es el que nos va a ofrecer una visión conjunta, o qué hacer con el legacy que sigue en un host… no hay por qué tirarlo todo si funciona, por ejemplo las campañas de marketing en SAS; otras igual si compensa hacerlo desde cero, por ejemplo el analytics, antes nos llegaba una petición y tardabas tres meses en resolverla, ahora lanzo una query y en nada tengo todos los datos en pantalla”.

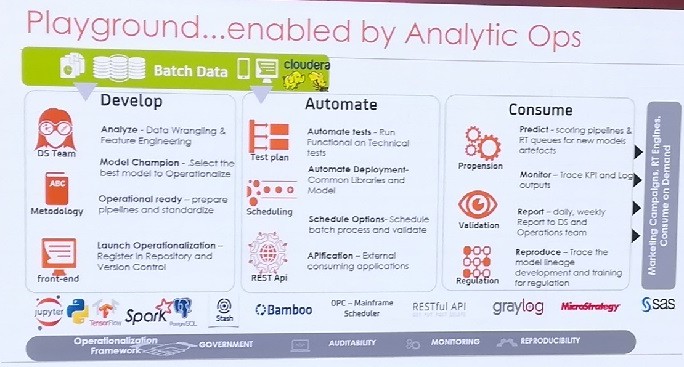

Bankia ha construido una plataforma Big Data para todos los usos (diseño), basado en la flexibilidad del open source (decoración), al que se le ha dotado de una serie de reglas (compliance) y donde los data scientifics tienen libertad para jugar (patio de recreo), con ingestas en modo batch y en modo near-real-time (planos). “Antes cada miembro de la familia estaba en diferentes estancias, y tardaban de seis a ocho meses en lanzar un producto; ahora, todos trabajan en un mismo entorno unificado siguiendo las mismas reglas, y tardan dos semanas”, dice la ponente de Bankia. “Lo más importante ha sido el poder entender nuestras necesidades y los problemas de negocio que teníamos, y poder resolverlos para su industrialización”.

El proceso de renovación que se inició hace unos 18 meses, empezó a dar sus primeros frutos en mayo pasado, con el lanzamiento de notificaciones de eventos sobre clientes para cerrar ventas desde el call center (la típica llamada de comprobación cuando has hecho un gasto grande y ya de paso preguntarte si deseas un crédito inmediato preconcedido). Para el presente mes ya son 125 los eventos y 200 los modelos analíticos creados puestos en producción, con la idea de personalizar las ofertas y mejorar la aproximación a los clientes. “Ahora manejamos 3.000 variables nuevas de clientes -totalmente anonimizadas para garantizar el cumplimiento con la ley de protección de datos-, que nos ayudan a perfilar comportamientos, todo para encontrar el golden moment aplicando inteligencia de negocio. También sirve para prevenir fraudes, detección de accesos no autorizados y corregir amenazas. Nuestros siguientes pasos se encaminan a ‘domotizar la casa’, esto es, evolucionar hacia una plataforma cognitiva que aplique inteligencia artificial en todos los puntos, así como a la APIficación del streaming para crear y aplicar casos de uso (tanto propios hechos a medida como de terceros contrastados)”. Pero esto igual toca contarlo en el ExCel de Londres los próximos 22-25 de abril de 2018 en el evento global de Teradata Universe.