Netskope revela que más de un tercio de los datos compartidos en aplicaciones de IA generativa son datos personales regulados, aumentando riesgos de seguridad.

Netskope, una autoridad en soluciones de Secure Access Service Edge (SASE), ha desvelado en su último informe que más del 33% de los datos confidenciales introducidos en aplicaciones de IA generativa son datos personales regulados. Este informe destaca los crecientes desafíos que enfrentan las empresas para equilibrar la seguridad y la gestión de riesgos mientras adoptan estas innovadoras tecnologías.

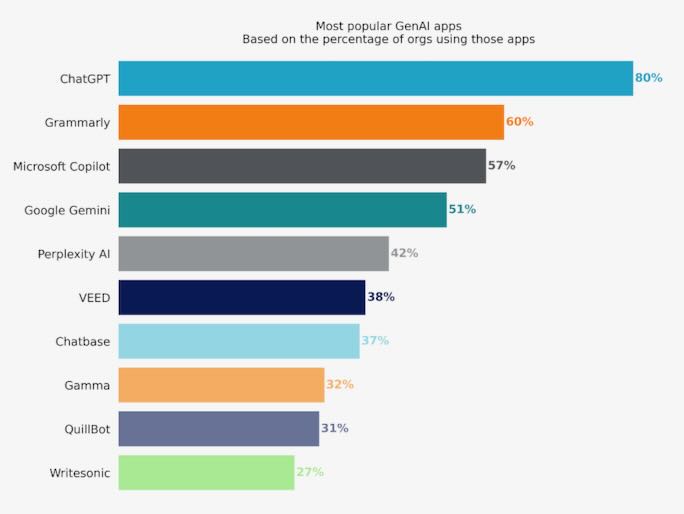

En los últimos 12 meses, el uso de IA generativa se ha triplicado, alcanzando un 96% de adopción entre las empresas encuestadas. El informe muestra que, en promedio, las empresas utilizan casi 10 aplicaciones de IA generativa, un aumento significativo comparado con las 3 aplicaciones de hace un año. En el caso del 1% de las empresas más avanzadas en adopción, este número ha escalado a un promedio de 80 aplicaciones, frente a las 14 del año pasado.

El informe de Netskope Threat Labs revela que los datos sujetos a control representan más de un tercio de los datos confidenciales compartidos con aplicaciones de IA generativa. Esta situación plantea un alto riesgo de filtraciones de datos que podrían resultar muy costosas para las empresas. La prevalencia de datos personales regulados en estas aplicaciones requiere una atención especial a las medidas de seguridad y a la prevención de pérdida de datos (DLP).

Tres cuartas partes de las empresas encuestadas han tomado medidas para bloquear al menos una aplicación de IA generativa, en un esfuerzo por limitar el riesgo de filtración de datos confidenciales. Sin embargo, menos de la mitad de estas empresas han implementado controles centrados en los datos para evitar el intercambio de información sensible, lo que indica una falta de adopción de soluciones avanzadas de DLP necesarias para habilitar de forma segura las aplicaciones de IA generativa.

Una preocupación emergente es el aumento del intercambio de código fuente propietario dentro de las aplicaciones de IA generativa, representando el 46% de todas las vulneraciones documentadas de la política de datos. Este fenómeno complica la gestión del riesgo y exige esfuerzos más robustos en DLP para mitigar posibles brechas de seguridad.

A pesar de los riesgos, el informe señala que el 65% de las empresas están adoptando medidas proactivas de seguridad, como la formación de usuarios en tiempo real para guiar sus interacciones con las aplicaciones de IA generativa. Esta formación ha demostrado ser efectiva, con un 57% de los usuarios modificando sus hábitos tras recibir alertas de asesoramiento.

James Robinson, director de seguridad de la información de Netskope, subraya la necesidad de una mayor inversión y atención para garantizar la seguridad de las aplicaciones de IA generativa. “Las empresas deben ser conscientes de que el uso de genAI puede exponer inadvertidamente información sensible, diseminar información falsa o incluso introducir contenido malicioso. Esto exige un planteamiento sólido de gestión de riesgos para proteger los datos, la reputación y la continuidad del negocio”, afirma Robinson.

El “Informe sobre la nube y las amenazas: AI Apps en la empresa” de Netskope también destaca que:

Netskope recomienda a las empresas revisar, adaptar y ajustar sus programas de protección específicamente para IA o genAI utilizando iniciativas como el NIST AI Risk Management Framework. Entre los pasos específicos para mitigar riesgos se incluyen:

ESET advierte sobre fraudes en reservas online y Wi-Fi públicas en Semana Santa y ofrece…

Kaspersky lanza KATA 7.0 con nuevas funciones NDR y EDR tras revelar que el 93%…

El grupo propietario de la española Aiuken Cybersecurity sigue adelante con su misión de crear…

La compañía advierte sobre "el riesgo de robo de datos hoy para su descifrado en…

La IA aplicada a la gestión documental reduce errores, ahorra tiempo y recorta costes operativos…

Su puesto actual en la compañía es el de presidente para la región conformada por…