Dynatrace anuncia un único pipeline para gestionar la ingesta de datos a escala de petabytes

OpenPipeline llega para trabajar con “datos heterogéneos de observabilidad, seguridad y negocio, proporcionando análisis unificados”.

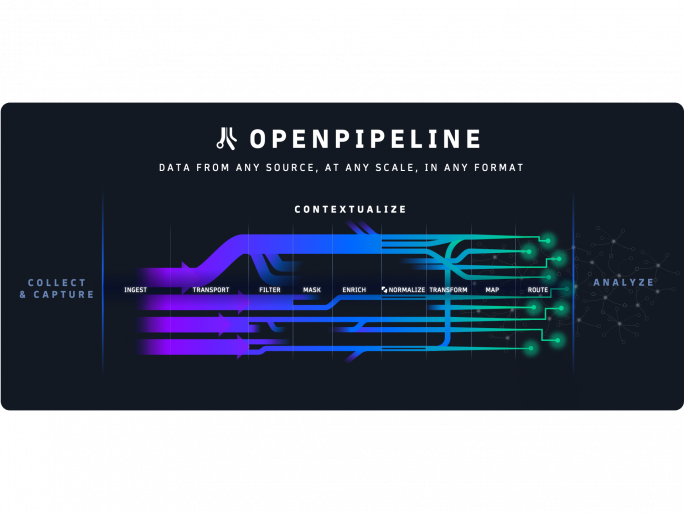

Dynatrace anuncia una tecnología de análisis y automatización de nombre OpenPipeline, que proporciona un único pipeline para la ingesta de datos a escala petabyte.

“Es una potente incorporación a la plataforma Dynatrace”, comenta el CTO de la compañía, Bernd Greifeneder. “Enriquece, converge y contextualiza datos heterogéneos de observabilidad, seguridad y negocio, proporcionando análisis unificados para estos datos y los servicios que representan”.

“Funciona con la IA hipermodal Davis de Dynatrace para extraer información significativa de los datos, impulsando una analítica robusta y una automatización fiable”, continúa explicando. También trabaja con otras tecnologías como Grail data lakehouse y la topología Smartscape.

Dynatrace calcula que OpenPipeline “permitirá a nuestros clientes evaluar flujos de datos entre cinco y diez veces más rápido que las tecnologías heredadas. También creemos que la convergencia y contextualización de datos dentro de Dynatrace facilita el cumplimiento normativo y las auditorías, al tiempo que empodera a más equipos dentro de las organizaciones para obtener visibilidad inmediata sobre el rendimiento y la seguridad de sus servicios digitales”, dice Greifeneder.

La idea es que las compañías pueden gestionar datos en entornos híbridos y multicloud, con acceso a respuestas y automatizaciones impulsadas por inteligencia artificial.