Data Fabric es la gran apuesta de NetApp para los entornos multicloud

Durante el congreso NetApp Insight, el fabricante ha desgranado su estrategia para simplificar y orquestar los entornos heterogéneos en la nube, de creciente adopción en la industria.

Esta semana ha tenido lugar en Londres el congreso NetApp Insight, donde el fabricante de soluciones de almacenamiento ha confirmado su apuesta por los entornos híbridos y multicloud y su visión Data Fabric para simplificar la gestión de todos esos recursos desplegados en distintos lugares y modalidades, más allá de la infraestructura interna de las organizaciones.

No era fácil para un fabricante de soluciones de almacenamiento dejar a un lado el suculento negocio generado con la venta de hardware y ‘appliances’, pero tras la llegada de George Kurian a la presidencia y dirección ejecutiva de NetApp en 2011, se definió una hoja de ruta muy clara, marcada por el desarrollo software como principal generador de ingresos. Un software que fuera capaz de responder a las necesidades reales de sus clientes, de forma independiente a los recursos de hardware y servicios que estuvieran consumiendo, incluyendo los sistemas tradicionales.

El tiempo dio la razón a Kurian y su equipo: los entornos híbridos y multicloud han terminado por imponerse en un mundo donde los datos y las aplicaciones son cada vez más importantes para la continuidad de los negocios.

En esa hoja de ruta también se contempló el futuro a largo plazo, de tal forma que las soluciones propuestas fueran válidas para la tecnología venidera tanto en los entornos ‘on-premise’ como en la nube privada o híbrida, la tan manida transformación digital, que no es otra cosa que la modernización de los recursos de TI.

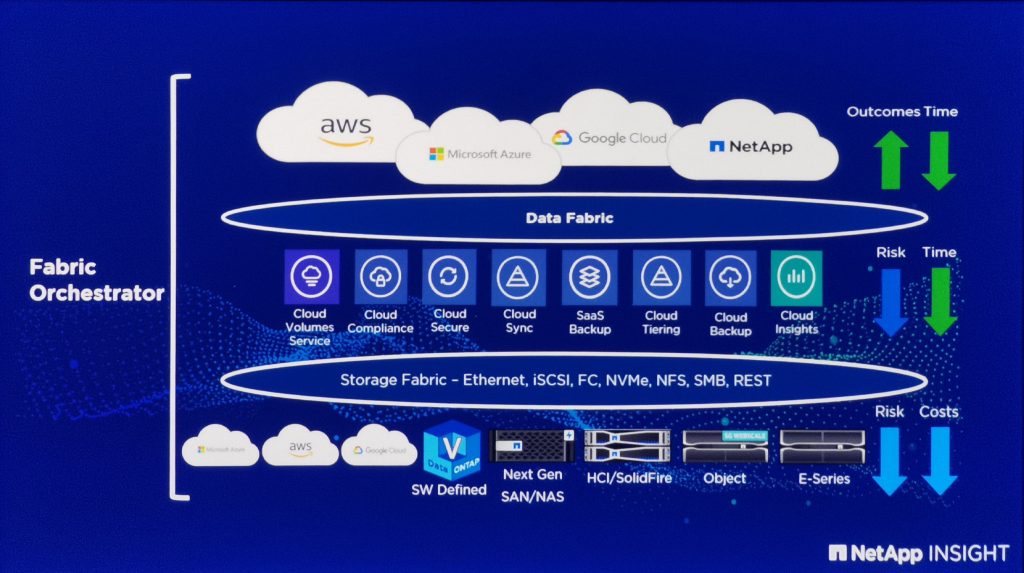

Y Data Fabric es el pegamento que une todos los entornos para que puedan encajar en una sola pieza, logrando de esta forma una visibilidad enorme mientras se automatizan y simplifican las operaciones. All-Flash, Object Storage, HCI, Cloud Volumes, NetApp Files… son algunas de las piezas de NetApp que conforman ese puzle al que todos llamamos multicloud, donde también se pueden encajar entornos tan variopintos como los legacy o los proveedores de nube pública hiperescalares como AWS, Microsoft Azure o Google Cloud.

El acercamiento de Data Fabric es el de poder conectar todos esos elementos y optimizarlos hasta tal punto que es posible saber exactamente dónde se encuentran las aplicaciones y datos dentro de ese conglomerado de recursos, así como quién está accediendo a ellos en todo momento. Además de la eficiencia que supone esto para los administradores, también se asegura el cumplimiento de las últimas normativas de protección de datos como la GDPR.

En este proceso de creación de un Data Fabric, lo más complicado es, según Matt Watts, CTO y director de Estrategia de NetApp para EMEA, “facilitar el descubrimiento de todo lo que está pasando en esos entornos heterogéneos, procesarlo con herramientas analíticas y generar informes en tiempo real de cualquier suceso”. En su conjunto, Data Fabric proporciona una visión unificada de todo lo que ocurre para una mejor orquestación de los recursos: “Los datos correctos, en el lugar correcto, en el momento correcto y con las características correctas, ese es el acercamiento de NetApp con Data Fabric”, añadía.

HCI, más allá de la escalabilidad lineal

Durante el encuentro de este cronista con Watts también tuvimos la oportunidad de charlar sobre los entornos hiperconvergentes, donde NetApp está teniendo una presencia muy activa a través de su solución HCI. En EMEA, el crecimiento en ventas de estas cabinas se encuentra por encima de la media, aunque hay un detalle interesante que no se debe pasar por alto y que el directivo nos explicó: La idea original de la hiperconvergencia era unir en una misma máquina computación, almacenamiento, conectividad y software para permitir una escalabilidad más eficiente y rápida a medida que se necesitaban más recursos.

Esto es válido para muchos escenarios donde los recursos crecen linealmente, como los despliegues de escritorios virtuales (VDI), pero NetApp ha encontrado que hay limitaciones en la forma de aplicar esa hiperescalabilidad: “Cuando los requisitos de computación escalan de forma distinta a los de almacenamiento, la hiperconvergencia puede no ser la mejor opción, tampoco la más económica, por lo que es necesaria una alternativa más flexible. Nuestra solución HCI cuenta con una arquitectura que permite escalar estos recursos de forma independiente, con más opciones de procesamiento o almacenamiento que las configuraciones estándar, pero siempre bajo la filosofía de poder incorporar nuevos módulos fácilmente a medida que se necesitan”, finalizaba Watts.