AWS anuncia nuevas instancias y chips en Amazon EC2 para cargas de trabajo intensivas

La nube de AWS se está definiendo para soportar más cargas de trabajo de alto rendimiento mientras se reduce el consumo eléctrico. Las nuevas instancias, basadas en chips ARM, se han diseñado para conseguirlo.

Durante el congreso AWS re:Invent 2022 que se está celebrando en Las Vegas, la compañía está anunciando una serie de novedades a nivel de computación y redes que pretenden mejorar el rendimiento por vatio y el coste en cargas de trabajo HPC, redes y aprendizaje profundo, áreas cada vez más demandadas en la nube pública.

Peter DeSantis, Senior Vice President of AWS Utility Computing, AWS, ha sido el encargado de desvelar tres nuevas instancias para Amazon Elastic Compute Cloud (EC2), el servicio de computación del proveedor.

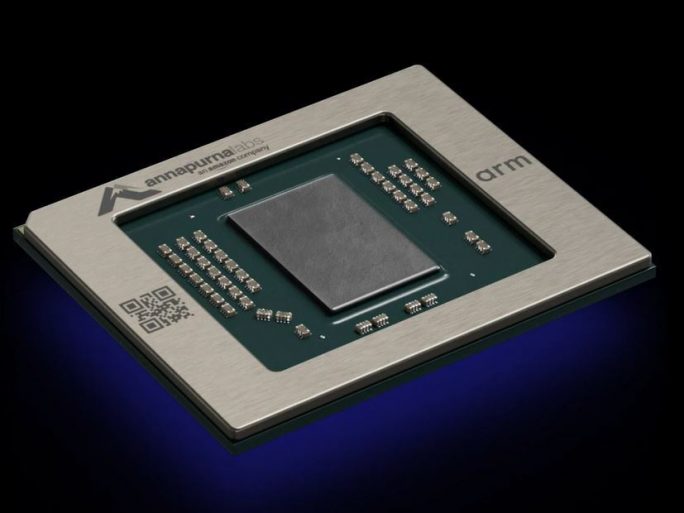

Por un lado nos encontramos con la instancia Hpc7g, que contará con los nuevos chips Graviton3E, basados en arquitectura ARM. Estos microprocesadores han sido diseñados por Annapurna Labs, compañía subsidiaria de Amazon.

Su objetivo es mejorar las cargas de trabajo intensivas tradicionales de HPC mientras se reduce el consumo energético. Según DeSantis, estos chips duplican el rendimiento en operaciones de coma flotante con respecto a la generación anterior, lo que ofrece una mejor relación precio/rendimiento para estos procesos HPC a escala y complejos dentro de Amazon EC2.

Por su parte, las nuevas instancias C7gn se han diseñado específicamente para soportar cargas de trabajo intensivas en las redes que transfieren los datos. De esta forma, dispositivos virtuales de red como cortafuegos, routers y procesos de balanceo de carga, así como cifrado de datos contarán con una mayor eficiencia y ancho de banda para reducir los tradicionales cuellos de botella de estos componentes virtualizados en el tráfico de las redes.

Las instancias C7gn incorporan la nueva generación de tarjetas AWS Nitro v5 (en la imagen de portada), que duplican el número de transistores y aceleran las funciones de Entrada/Salida, de tal forma que se descarga a las CPUs de estos procesos tan específicos. Según declaraba DeSantis, Las nuevas tarjetas Nitro de AWS permiten que las instancias C7gn ofrezcan hasta el doble del ancho de banda de la red y hasta un 50 % más de rendimiento de procesamiento de paquetes por segundo, y una latencia de red reducida.

Por último, AWS ha mostrado las capacidades de las nuevas instancias Inf2, específicas para implementaciones de aprendizaje profundo en los casos más intensivos.

Para hacernos una idea, cada vez existen más modelos de aprendizaje profundo con más de 100.000 millones de parámetros, lo que supone un procesamiento de datos sin precedentes para su ejecución en la nube pública.

El proveedor pretende acelerar estos procesos que hasta hace poco tiempo se constituían con pocos millones de parámetros y que ahora se han multiplicado exponencialmente (tanto en tamaño como en complejidad) debido al gran avance surgido en los procesos de inteligencia artificial y aprendizaje profundo. AWS calcula que este número de parámetros que se tienen en cuenta se ha multiplicado por 500 desde 2019.

Las instancias Inf2 estarán gobernadas por los chips Inferentia2, diseñados para admitir estas cantidades de parámetros y distribuir las inferencias en varios chips para optimizar el rendimiento de los modelos de aprendizaje.